Попередні нейронні проблеми чистої гри в гольф ( це і що ) надихнув мене поставити нове завдання:

Змагання

Знайдіть найменшу нейронну мережу подачі таким чином, що за будь-якого 4-мірного вхідного вектора з цілими записами в мережа виводить з помилка координат, строго менша за .

Допустимість

Для цього завдання нейронна мережа, що подається, визначається як склад шарів . Шар є функцією , що визначається матрицею ∈ R м × п з ваг , вектор Ь ∈ R м від ухилів , а функція активації F : R → R , який застосовується координатно мудрий:

Оскільки функції активації можуть бути налаштовані на будь-яке завдання, нам потрібно обмежити клас функцій активації, щоб цей виклик був цікавим. Дозволені наступні функції активації:

Ідентичність.

ReLU.

Softplus.

Гіперболічна дотична.

Сигмоїдний.

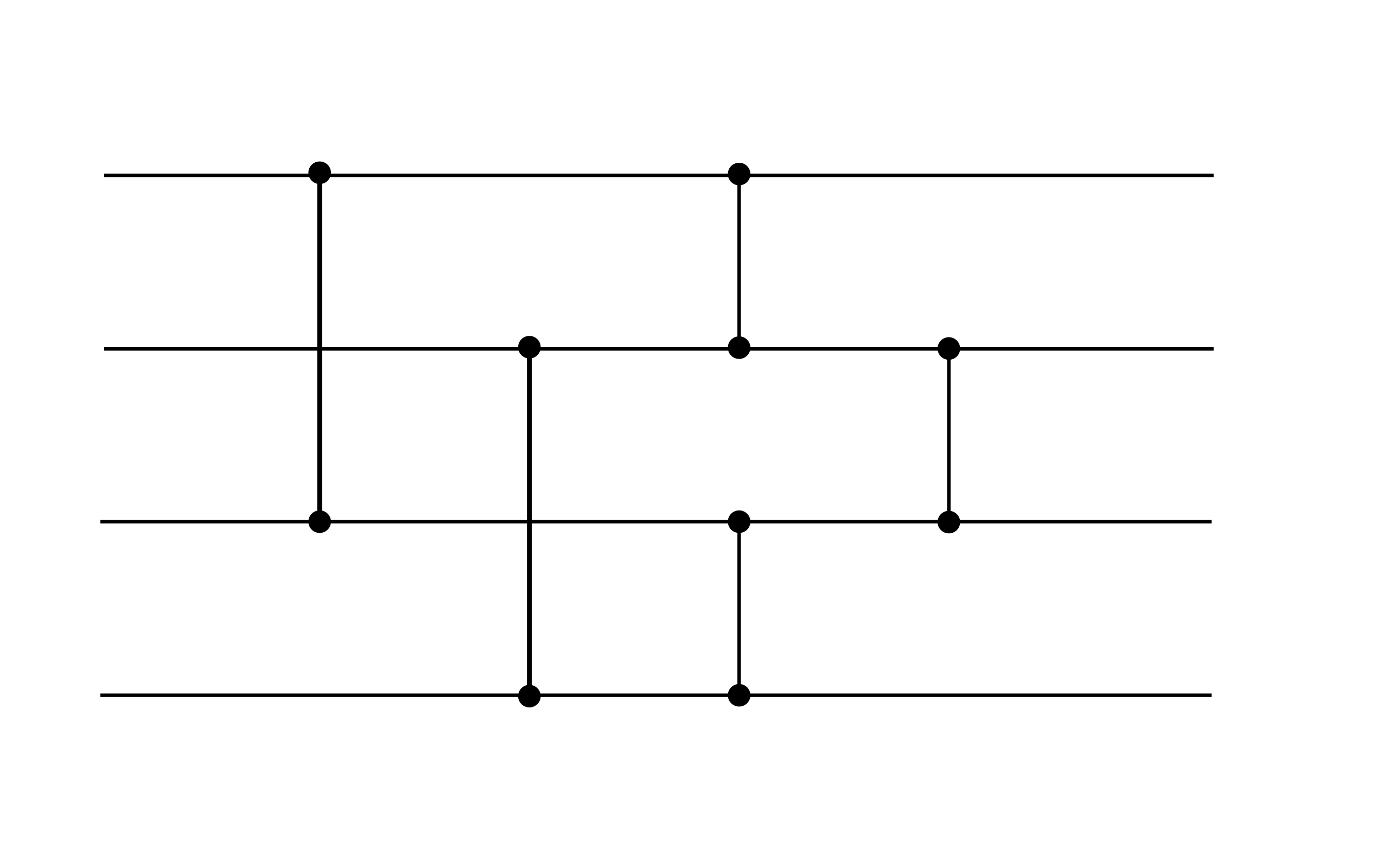

В цілому допустима нейронна сітка має вигляд для деякого , де кожен шар визначається вагами , зміщенням та функцією активації із наведеного списку. Наприклад, допустима наступна нейронна сітка (хоча вона не відповідає цілі ефективності цього завдання, вона може бути корисним пристосуванням):

Цей приклад демонструє два шари. Обидва шари мають нульовий зміщення. Перший шар використовує активацію ReLU, а другий використовує активацію ідентичності.

Оцінка балів

Ваш бал - це загальна кількість ненульових ваг і ухилів.

(Наприклад, наведений вище приклад має оцінку 16, оскільки вектори зміщення дорівнюють нулю.)